videoEffect.duration

videoEffect.resolution

videoEffect.ratio

Wan 2.2 Open-Source-KI-Videogenerator

Entfessle die Kraft der hochwertigen Videogenerierung mit Wan 2.2 – Jetzt Open Source

Was ist Wan 2.2?

Alibaba Wan 2.2: Der smartere, schnellere KI-Bild- und Video-Generator

Wan 2.2 ist ein fortschrittliches KI-Modell, entwickelt von Wan AI – einer Forschungsinitiative in Zusammenarbeit mit Alibaba. Es konzentriert sich auf multimodale Content-Erstellung, insbesondere auf hochwertige KI-Videoerzeugung aus Text oder Bildern. Die Veröffentlichung erfolgte Ende Juli 2025 und stellt ein bedeutendes Upgrade gegenüber Wan 2.1 dar – mit spürbarer Leistungssteigerung dank Mixture-of-Experts-Architektur (MoE).

Open-Source-Zugang zum KI-Bild- und Video-Generator Wan 2.2

Alibaba Wan 2.2 steht unter der Apache-2.0-Lizenz und ist vollständig quelloffen. Das Modell und seine Komponenten können sowohl für Forschungs- als auch für kommerzielle Zwecke frei genutzt und heruntergeladen werden. Dieser offene Ansatz macht Wan 2.2 zu einer flexiblen Grundlage für Entwickler:innen, die neue Video-Tools entwickeln oder individuelle Pipelines integrieren möchten.

Wan 2.2 KI-Video-Modelle

T2V-A14B: Text-zu-Video-Modell

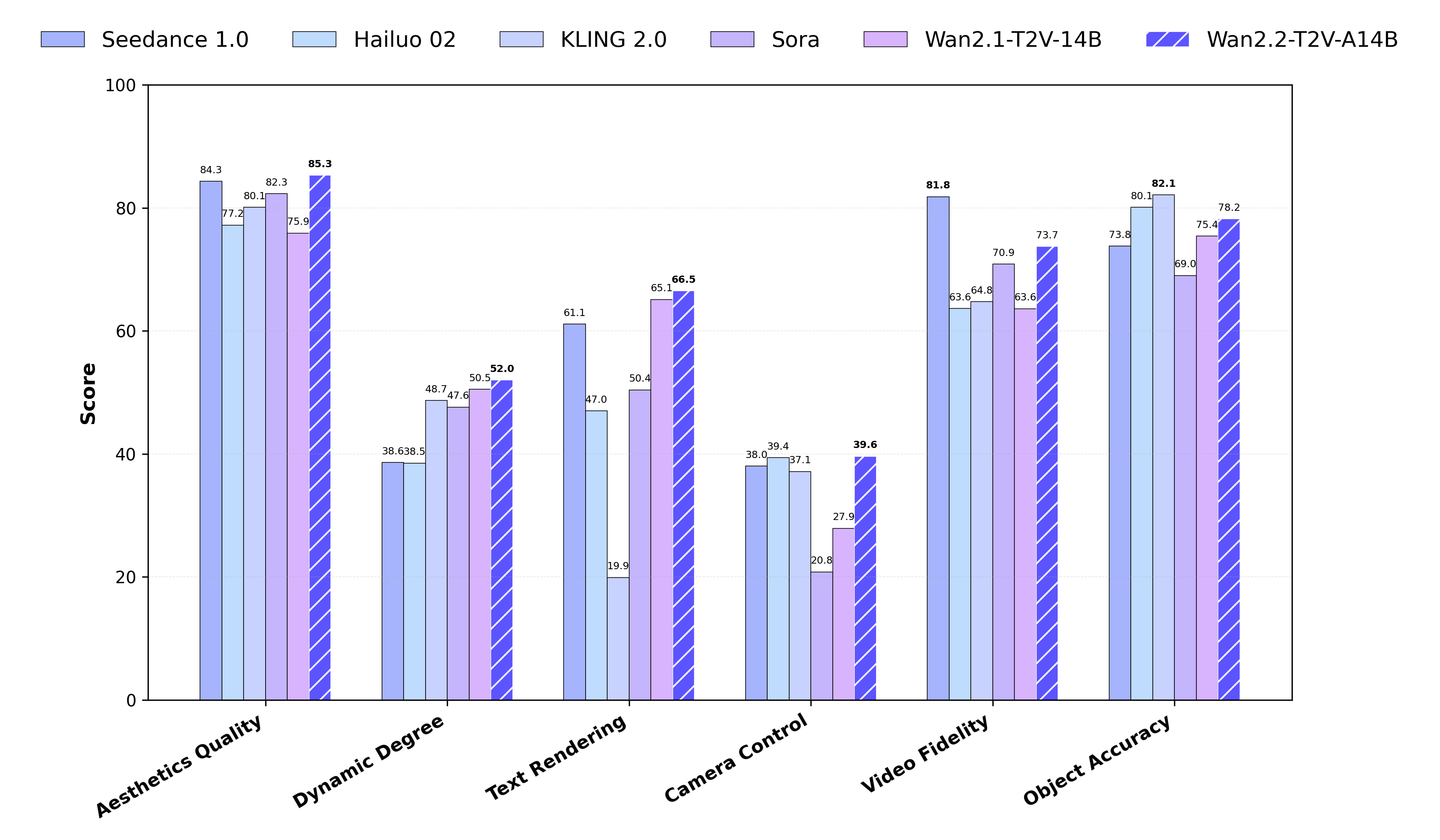

T2V-A14B ist ein leistungsstarkes Wan-2.2-Modell mit Mixture-of-Experts-(MoE)-Architektur. Es generiert 5-Sekunden-Videos in 480p- und 720p-Auflösung. Im Wan-Bench-2.0-Benchmark übertrifft es mehrere führende kommerzielle KI-Videogeneratoren und überzeugt in Bewegungsqualität, Genauigkeit der Eingabeinterpretation und visuelleRe-editierte Übersetzungm Stil.

I2V-A14B: Bild-zu-Video-Modell

Das Modell I2V-A14B wandelt statische Bilder in flüssige Videosequenzen um. Ebenfalls auf der MoE-Architektur basierend, unterstützt es Ausgaben in 480p und 720p. Im Vergleich zu früheren Wan-Video-Versionen bietet es weniger unnatürliche Kamerabewegungen und mehr Konsistenz in stilisierten oder künstlerischen Szenen.

TI2V-5B: Hybrides Modell für Text- und Bild-zu-Video-Generierung

TI2V-5B ist ein kompakRe-editing translated copytes, aber leistungsstarkes Modell für Text-zu-Video- und Bild-zu-Video-Aufgaben. Es nutzt Wan2.2-VAE zur effizienten Videokomprimierung bei gleichzeitig hoher Qualität. Mit Unterstützung für 720p bei 24 fps kann es auf einer einzelnen Consumer-GPU wie der RTX 4090 betrieben werden – und zählt damit zu den schnellsten Modellen von Wan AI für praktische und wissenschaftliche Anwendungen.

Die wichtigsten Funktionen des Open-Source-KI-Videogenerators Wan 2.2

Kinoreife Kontrolle bei der Videoerstellung mit Wan AI

Wan 2.2 bietet präzise Kontrolle über Licht, Farbe und Bildausschnitt – ideal für kinoreife Videos mit konsistenter Bildsprache. Perfekt für Storytelling und professionelle Video-Workflows mit dem KI-Videogenerator von Wan.

Fortschrittliche MoE-Architektur von Wan 2.2

Das Modell verwendet ein Mixture-of-Experts-(MoE)-System, um die Generierungsqualität und -geschwindigkeit zu steigern, ohne die Rechenkosten zu erhöhen. Dadurch bietet Wan 2.2 von Alibaba höhere Kapazität und stabilere Ergebnisse.

Hohe Auflösung bei effizienter Leistung

Wan 2.2 ermöglicht die Videoerstellung in 720p bei 24 fps auf handelsüblichen GPUs. Es zählt zu den schnellsten Modellen seiner Klasse – geeignet für Industrie und Forschung.

Skalierte Daten verbessern Realismus und Bewegung

Im Vergleich zu Wan 2.1 wurde das neue Modell mit 65 % mehr Bildern und 83 % mehr Videos trainiert. Das verbessert die Bewegungsgenauigkeit, Szenenvielfalt und visuelle Qualität in den generierten Videos von Wan 2.2.

Text-zu-Video und Bild-zu-Video unterstützt

Wan 2.2, der KI-Videogenerator, verwandelt Texteingaben oder statische Bilder in dynamische Szenen. Die enthaltenen Modelle sind für text- und bildbasierte Workflows optimiert.

Präzise Verarbeitung komplexer Eingabebefehle

Wan 2.2 versteht komplexe Prompts besser – auch mit mehreren Objekten oder stilisierten Anforderungen. So erhalten Nutzer klarere, verlässlichere Ergebnisse bei komplexen oder abstrakten Inhalten.

Wie greift man auf Wan 2.2 online zu?

Probiere Wan 2.2 TI2V-5B auf Hugging Face Space aus

Teste den KI-Videogenerator Wan 2.2 direkt auf Hugging Face Space aus. Das TI2V-5B-Modell unterstützt die Text-zu-Video sowie Bild-zu-Video-Generierung in 720p bei 24fps.

Verwende Wan 2.2 Plus auf der WanVideo-Website

Die offizielle Wan AI-Website gewährt Zugang zu Wan 2.2 Plus, einer erweiterten Version des Modells mit zusätzlichen Tools und vordefinierten Vorlagen. Es richtet sich an Kreative, die schnellere Workflows und eine bessere Kontrolle über das cineastische Ergebnis wünschen. Beachte bitte, dass der Zugang zu Wan 2.2 Plus momentan kostenpflichtig ist.

So richtest du Wan 2.2 lokal ein und nutzt es

Schritt 1: Repository klonen

Lade zunächst die offizielle Codebasis für Wan 2.2 von GitHub herunter. Dieses Repository enthält alle notwendigen Dateien, um das Modell lokal auszuführen.

Schritt 2: Abhängigkeiten installieren

Nach dem Klonen musst du die notwendigen Bibliotheken installieren. Wan AI benötigt Python und mindestens PyTorch 2.4.0, damit es ordnungsgemäß funktioniert. Dies stellt sicher, dass der KI-Videogenerator Wan 2.2 auf deinem System reibungslos funktioniert.

Schritt 3: Modell herunterladen

Wähle das Modell, das deinen Anforderungen entspricht: - T2V-A14B: Text-zu-Video - I2V-A14B: Bild-zu-Video - TI2V-5B: Hybrid (Text + Bild), unterstützt 720p bei 24 FPS Weitere Informationen und Downloads für jedes Modell findest du auf Hugging Face und ModelScope.

Schritt 4: Videoerstellung durchführen

Sobald alles eingerichtet ist, kannst du Videos generieren, indem du eine Eingabe – entweder einen Text oder ein Bild – machst. Das Wan 2.2 System verarbeitet deine Eingabe lokal und liefert hochauflösendes Videomaterial, bei dem du vollständige Kontrolle über Bewegung, Komposition und Stil hast.

Lade den Wan 2.2 ComfyUI Workflow

Wan 2.2 TI2V-5B Workflow für ComfyUI

Ein fertiger ComfyUI-Workflow für Wan 2.2 TI2V-5B ermöglicht die kombinierte Text-zu-Video- und Bild-zu-Video-Erstellung über eine einfache visuelle Oberfläche. Hier findest du eine Anleitung zur Einrichtung und Nutzung im Wan 2.2 ComfyUI Tutorial. Es wird empfohlen, für die besten Ergebnisse die neueste Entwicklungs-Version von ComfyUI zu nutzen.

Voraussetzungen für die Nutzung von Wan AI in ComfyUI

Um Wan 2.2 in ComfyUI auszuführen, musst du manuell das passende Diffusionsmodell, VAE und Textencoder-Dateien installieren. Folge den offiziellen Schritt-für-Schritt-Anweisungen, um jedes Modul zu verbinden. Eine GPU mit mindestens 8 GB VRAM wird für eine reibungslose Videoerstellung empfohlen.

Workflow-Optionen: T2V, I2V und Hybrid

ComfyUI unterstützt drei Workflow-Optionen: Text-zu-Video (T2V), Bild-zu-Video (I2V) und Hybrid (TI2V). Jeder Workflow verwendet eine unterschiedliche Modellkonfiguration. Du kannst basierend auf deinem Eingabetyp und deinen Generierungszielen auswählen. Eingabeaufforderungen, Frame-Länge und Auflösung können innerhalb des Workflows individuell angepasst werden.

So funktioniert Wan 2.2

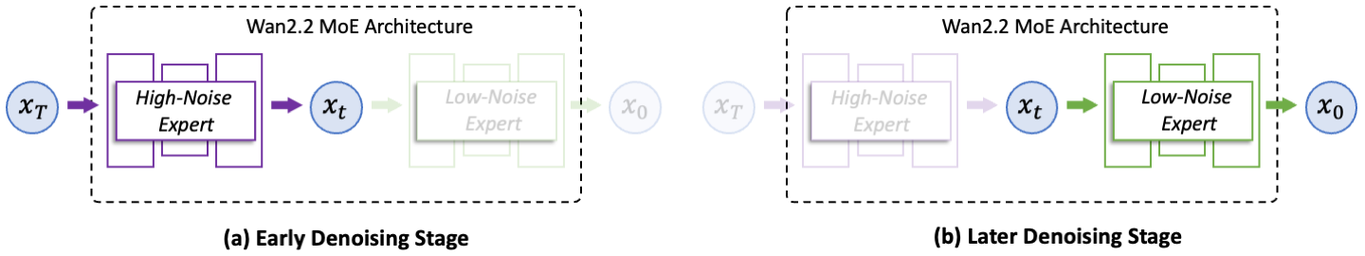

Mixture-of-Experts (MoE) Architektur

Wan 2.2 verwendet eine Mixture-of-Experts (MoE) Struktur, um die Generierungsqualität zu verbessern, ohne die Inferenzkosten zu erhöhen. Zwei spezialisierte Expertenmodelle – eines für hohes Rauschen und eines für niedriges Rauschen – arbeiten nacheinander, um verschiedene Phasen des Rauschreduzierungsprozesses zu verarbeiten. Im Vergleich zu Wan 2.1 optimiert dieses Design sowohl das Layout als auch die Detailtreue, während der Speicherbedarf auf Standard-GPUs stabil bleibt.

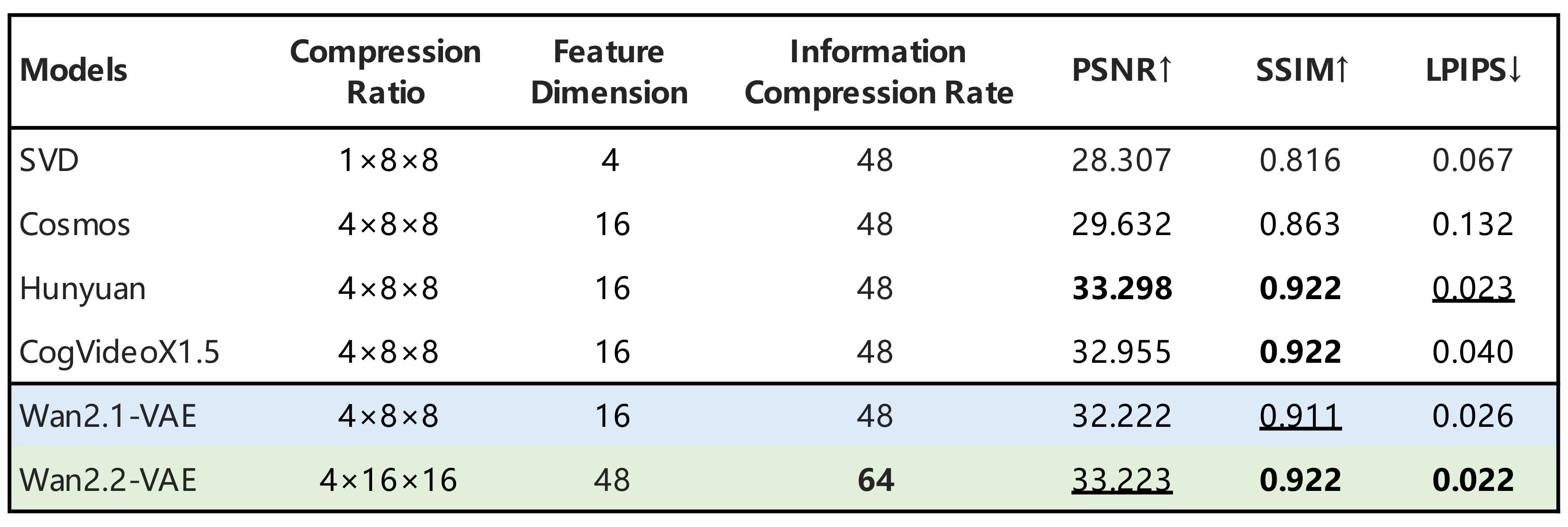

Hocheffizientes Hybrid-Modell TI2V

Um eine schnellere und leichtere Bereitstellung zu ermöglichen, stellt Alibaba Wan 2.2 ein kompaktes Modell namens TI2V-5B vor. Es nutzt ein hochkomprimiertes VAE, um 720p-Videos mit 24 fps in weniger als 9 Minuten auf einer einzelnen Consumer-GPU zu erzeugen. Diese Version unterstützt sowohl Text-zu-Video- als auch Bild-zu-Video-Prozesse innerhalb einer einheitlichen Pipeline.

Wan 2.2 vs. führende KI-Video-Modelle

Im Vergleich zu früheren Versionen des Wan-Videomodells zeigt Wan 2.2 deutlich weniger Validierungsverlust, was bedeutet, dass die von ihm erzeugten Videos realistischer sind und besser mit menschlichen visuellen Erwartungen übereinstimmen. Benchmark-Tests zeigen, dass Wan AI mehrere führende Closed-Source-Modelle bei Bewegung, Details und Prompt-Genauigkeit übertrifft.

Demnächst: Integration des Wan KI-Videogenerators

Ab sofort kannst du unseren KI-Videogenerator kostenlos online auf videomaker.me ausprobieren – ohne Anmeldung. Wir arbeiten auch daran, vollständige Unterstützung für den KI-Videogenerator Wan 2.2 bereitzustellen, sodass du bald Videos mit fortschrittlicher Wan 2.2 KI-Technologie in Kinoqualität und schneller Leistung erstellen kannst.

Häufig gestellte Fragen zu Wan 2.2

Was ist Wan 2.2 und wer hat es entwickelt?

Wan 2.2 ist ein Open-Source-KI-Videogenerator, entwickelt von Wan AI – einer Forschungsinitiative von Alibaba. Mit seiner fortschrittlichen multimodalen Architektur erstellt das Modell hochwertige Videos aus Text- oder Bildeingaben.

Was unterscheidet Wan 2.2 von Wan 2.1 oder anderen Modellen?

Dank der Mixture-of-Experts-Architektur und moderner Komprimierungstechniken bietet Wan 2.2 eine verbesserte Qualität und Geschwindigkeit bei der Videoerzeugung – mit einer Ausgabe in 720p bei 24 fps. Im Vergleich zu führenden kommerziellen Modellen überzeugt es durch realistischere Bewegungen und präzisere Umsetzung der Prompts.

Welche Videomodelle bietet Wan 2.2?

Wan 2.2 umfasst drei Hauptmodelle: T2V-A14B (Text-zu-Video), I2V-A14B (Bild-zu-Video) sowie TI2V-5B, ein hybrides Modell mit hochwertiger Ausgabe für beide Modi.

Kann ich Wan 2.2 online nutzen, ohne etwas einzurichten?

Du kannst das Modell TI2V-5B direkt über Hugging Face testen oder mit Wan 2.2 Plus auf der offiziellen WanVideo-Website weitere Funktionen entdecken – ganz ohne Installation oder Programmierkenntnisse.

Wie kann ich den Stil meines Videos anpassen?

Mit Wan 2.2 kannst du gezielt ästhetische Parameter wie Beleuchtung, Komposition und Farben anpassen, um Videos mit einem einzigartigen, filmischen Stil zu erstellen.

Wie führe ich Wan 2.2 lokal auf meinem Computer aus?

Um Wan 2.2 lokal auszuführen, musst du das offizielle GitHub-Repository klonen, Abhängigkeiten wie PyTorch 2.4.0 oder höher installieren und das passende Modell (T2V, I2V oder TI2V) herunterladen. Nach der Einrichtung kannst du Videos direkt auf deinem Gerät aus Text- oder Bildeingaben erstellen. Für eine reibungslose Leistung wird eine GPU mit mindestens 24 GB VRAM empfohlen.

Ist Wan 2.2 vollständig Open Source?

Ja, Wan 2.2 ist vollständig Open Source veröffentlicht. Entwickler:innen, Forscher:innen und Kreative können die Modelle frei erkunden und individuell anpassen.

Kann ich Wan 2.2 auch mit einer Consumer-GPU nutzen?

Ja, Wan 2.2 lässt sich auch auf Consumer-GPUs wie der RTX 4090 ausführen – mit hochauflösender KI-Videoerzeugung in 720p bei 24 fps.