videoEffect.duration

videoEffect.resolution

videoEffect.ratio

广域网 2.2 开源 AI 视频生成器正式发布

释放电影级视频生成的潜力,广域网 2.2——现已开源

什么是 Wan 2.2?

阿里巴巴 Wan 2.2:更智能、更高效的 AI 视频生成器

Wan 2.2 是由 Wan AI 开发的先进 AI 模型,Wan AI 是阿里巴巴的研究项目之一。它专注于多模态内容生成,尤其擅长从文本或图像生成高质量视频。该模型于 2025 年 7 月下旬发布,相较于 Wan 2.1,性能大幅提升,采用了专家混合(MoE)架构。

Wan 2.2 AI 视频生成器的开源访问

阿里巴巴的 Wan 2.2 在 Apache 2.0 许可下发布,完全开源。模型及其组件可以下载,适用于科研和商业领域。这种开放方式使 Wan 2.2 成为开发者构建新型广域网视频工具或集成自定义管道的灵活平台。

Wan 2.2 AI 视频模型

T2V-A14B:文本转视频模型

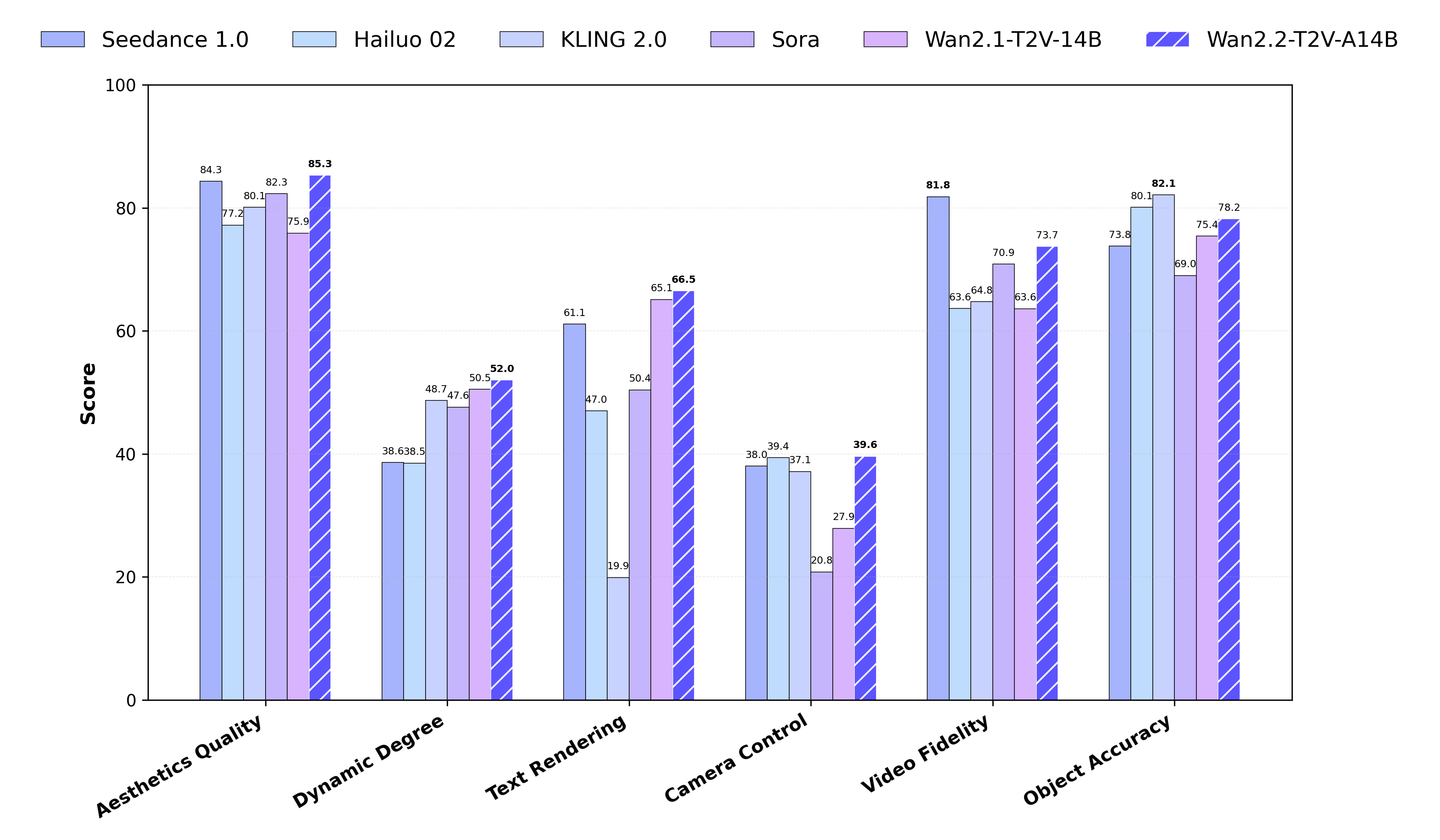

T2V-A14B 是一款高性能的 Wan 2.2 模型,采用混合专家(MoE)架构。它生成 5 秒长的视频,支持 480P 和 720P 分辨率。在 Wan-Bench 2.0 基准测试中,该模型超越了多款领先的商业 AI 视频生成器,表现出色,尤其在运动质量、响应准确性和视觉风格方面。

I2V-A14B:图像转视频模型

I2V-A14B 模型专注于将静态图像转换为平滑的视频序列。它也基于 MoE 架构,支持 480P 和 720P 输出。与早期版本的广域网视频相比,它减少了不自然的相机移动,并在风格化或艺术场景中提供了更高的连贯性。

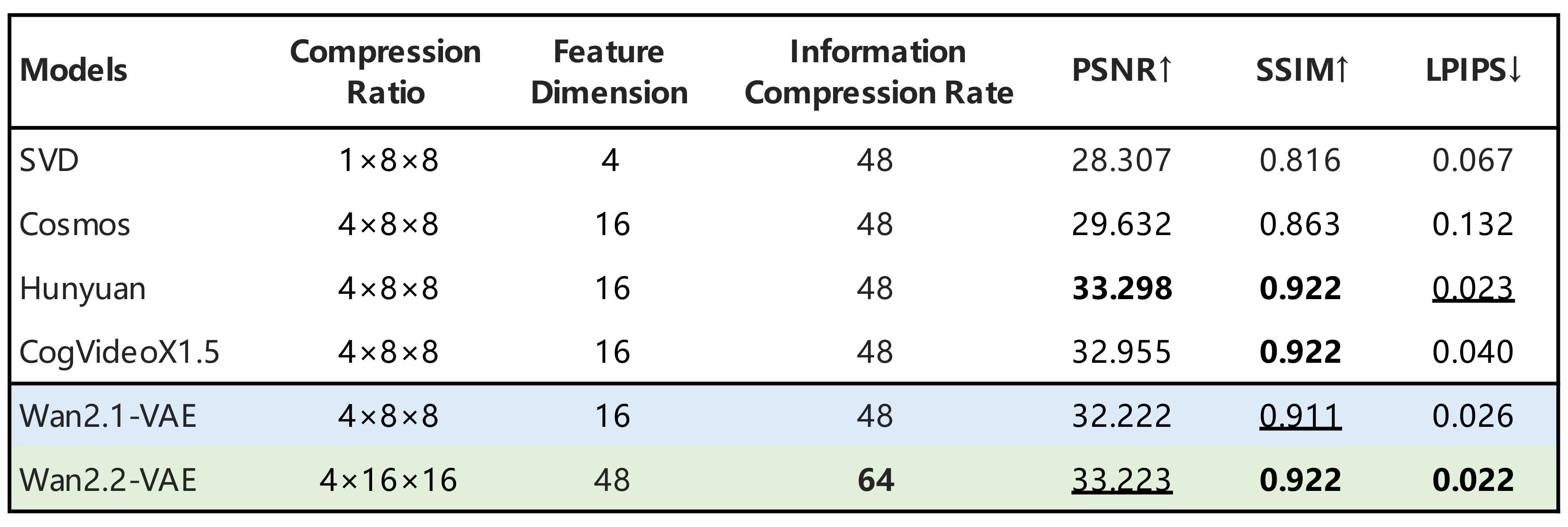

TI2V-5B:混合文本与图像的视频生成器

TI2V-5B 是一款轻量且高效的模型,专为文本转视频和图像转视频任务优化设计。它采用 Wan 2.2-VAE 技术,高效压缩视频并保持优质画质。支持 720P 24fps 输出,能够在如 RTX 4090 等消费级 GPU 上顺畅运行。这使得它成为现今最快的广域网 AI 模型之一,适用于各类实际应用与学术研究。

Wan 2.2 开源 AI 视频生成器核心亮点

Wan AI 视频创作的电影级控制

Wan 2.2 提供对光影、色彩和画面构图的精确控制,帮助用户创作具有统一风格和电影质感的视频,适用于故事叙述和商业级视频工作流。

Wan 2.2 采用先进 MoE 架构

该模型使用混合专家(MoE)架构,在不增加计算成本的前提下提升生成速度和画质,这让阿里巴巴 Wan 2.2 拥有更强的处理能力和更稳定的输出效果。

高分辨率输出,性能高效

Wan 2.2 支持在标准消费级 GPU 上以 720p、24fps 生成视频,是同类中速度领先的模型之一,广泛应用于行业与学术领域。

大规模的数据提升了真实感与运动表现

相比于 Wan 2.1,新版模型在训练中使用了多 65% 的图像和多 83% 的视频,在 WAN 视频生成中显著提升了运动精度、场景多样性和画面质量。

支持文本转视频与图像转视频

Wan 2.2 AI 视频生成器可将文本提示或静态图像转化为动态场景,支持文本驱动和图像驱动两种工作流程,满足多样化创作需求。

精准理解复杂提示

Wan 2.2 能更准确地理解复杂的生成请求,包括多物体和风格化提示,帮助用户在创作复杂或抽象内容时,获得更清晰、可预测的结果。

如何在线访问 Wan 2.2?

在 Hugging Face Space 上试用 Wan 2.2 TI2V-5B

您可以在 Hugging Face Space 上直接测试 Wan 2.2 AI 视频生成器。TI2V-5B 模型支持文本转视频和图像转视频的生成,分辨率为 720p,帧率为 24fps。

在 WanVideo 网站使用 Wan 2.2 Plus

官方的 Wan AI 网站 提供访问 Wan 2.2 Plus 的服务,这是该模型的高级版本,包含更多工具和预设模板。它专为需要更快工作流程和电影般的输出效果控制的创作者设计。请注意,当前访问 Wan 2.2 Plus 需要付费。

如何在本地安装和运行 Wan 2.2

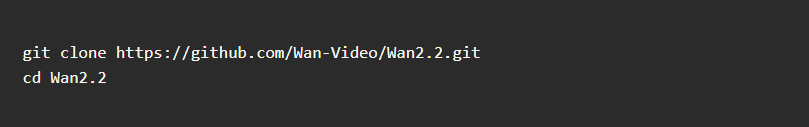

步骤 1:克隆代码库

首先,访问 GitHub 下载官方代码库。此代码库包含运行该模型所需的文件。

步骤 2:安装依赖库

完成代码库克隆后,安装必要的库。Wan AI 需要 Python 和 PyTorch 2.4.0 或更高版本才能顺利运行,这样可以确保 Wan 2.2 AI 视频生成器在您的系统上正常工作。

步骤 3:下载模型

选择适合您需求的模型: - T2V-A14B:文本转视频 - I2V-A14B:图像转视频 - TI2V-5B:混合模式(文本 + 图像),支持 720p 24FPS 您可以在 Hugging Face 和 ModelScope 下载并了解更多模型信息。

步骤 4:生成视频

完成设置后,您可以通过输入提示(文本或图像)生成视频。Wan 2.2 系统将在本地处理您的输入,输出高分辨率视频内容,并完全控制视频的运动、构图和风格。

获取广域网 2.2 的 ComfyUI 工作流

Wan 2.2 TI2V-5B ComfyUI 使用流程

Wan 2.2 TI2V-5B 的 ComfyUI 工作流,通过简单的可视化界面实现文本和图像混合生成视频。有关设置指南和使用说明,请参考此 Wan 2.2 ComfyUI 教程。推荐使用 ComfyUI 最新开发版本,以确保最佳效果。

Wan AI ComfyUI 安装要求

要在 ComfyUI 中运行 Wan 2.2,您需要手动安装正确的扩散模型、VAE 和文本编码器文件。请按照官方逐步指南连接每个组件。为了确保视频生成流畅,建议使用显存 8GB 以上的 GPU。

工作流选项:T2V、I2V 和混合模式

ComfyUI supports three wan video workflows: text-to-video (T2V), image-to-video (I2V), and hybrid (TI2V). Each uses a different model setup. You can choose based on your input type and generation goals. Prompt settings, frame length, and resolution can all be customized within the workflow.

广域网 2.2 如何运作?

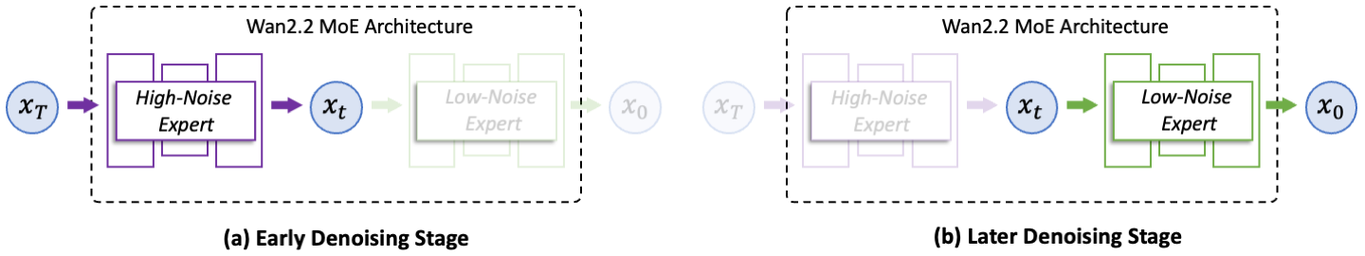

专家混合架构(MoE)

广域网 2.2 采用专家混合(MoE)架构,无需增加推理成本即可提升生成质量。两个专门的专家模型——分别处理高噪声和低噪声阶段——依次完成去噪的不同环节。与广域网 2.1 相比,该设计在保持标准 GPU 内存占用稳定的同时,显著提升了布局和细节表现。

高效混合 TI2V 模型

为支持更快、更轻量的部署,阿里巴巴在广域网 2.2 中引入了紧凑型 TI2V-5B 模型。它通过高压缩 VAE,在单块消费级 GPU 上可在 9 分钟内生成 24fps 的 720p 视频。该版本支持文本生成视频(Text-to-Video)与图像生成视频(Image-to-Video),并在一个统一的流程中完成。

广域网 2.2 与主流 AI 视频模型对比

与早期版本相比,广域网 2.2 显著降低了验证损失,使生成的视频更逼真,符合人类视觉预期。基准测试显示,广域网 AI 在运动、细节和提示准确性方面优于多款主流闭源模型。

即将上线:广域网 AI 视频生成器集成

现在,你可以在 videomaker.me 免费试用我们的 AI 视频生成器,无需注册。我们也在积极为广域网 2.2 AI 视频生成器提供全方位支持,届时你将能够利用先进的广域网 AI 技术,快速生成电影质量的视频。

Wan 2.2 常见问题解答

Wan 2.2 是什么?由谁开发的?

Wan 2.2 是由阿里巴巴的研究计划 Wan AI 开发的开源 AI 视频生成器。它利用先进的多模态架构,根据文本或图像提示生成高质量视频。

Wan 2.2 与 Wan 2.1 或其他模型有什么不同?

Wan 2.2 采用专家混合(MoE)架构和高压缩技术,提升了生成质量和速度。它支持 720P@24fps 输出,在真实感、运动和提示准确性上优于领先的商业模型。

Wan 2.2 提供哪些视频模型?

Wan 2.2 提供三种主要模型:T2V-A14B(文本转视频生成),I2V-A14B(图像转视频任务)。TI2V-5B 是一种混合模型,高效支持两种模式并提供高质量输出。

我可以在不设置的情况下在线使用 Wan 2.2 吗?

是的。您可以在 Hugging Face 上尝试 TI2V-5B 模型,或者访问官方 WanVideo 网站,使用 Wan 2.2 Plus 探索更多功能。两种选项均无需安装或编程。

如何定制我的视频风格?

Wan 2.2 允许您微调光照、构图、色彩等美学参数,打造具有独特电影风格的视频。

如何在我的计算机上本地运行 Wan 2.2?

要在本地运行 Wan 2.2,您需要从官方 GitHub 仓库克隆代码,安装 PyTorch 2.4.0 或更高版本的依赖,并下载合适的模型(T2V、I2V 或 TI2V)。配置完成后,您可以直接在本地计算机上使用文本或图像提示生成视频。推荐使用至少 24GB 显存的 GPU,以确保流畅的性能。

Wan 2.2 是完全开源的吗?

是的,Wan 2.2 完全开源,开发者、研究人员和创作者可以自由探索和定制模型。

我可以在普通 GPU 上运行 Wan 2.2 吗?

是的,Wan 2.2 可以在普通 GPU(如 RTX 4090)上运行,生成 720P 分辨率和 24fps 的高清视频。